در چامه ۱۲، خطرهای هوش مصنوعی را بیان کردیم. در رویداد آینده تکنولوژی پیرامون هوش انسان در سایه هوش مصنوعی میزبان دو مهمان به صورت مشترک بودیم. امیر احمد حبیبی سال ۱۳۹۶ در رشته مهندسی کامپیوتر از دانشگاه امیرکبیر فارغالتحصیل شد. سپس این کارآفرین ایرانی در دانشگاه آلبرتا کانادا به تحصیل در رشته علوم کامپیوتر پرداخت. حبیبی هماکنون مدیر فنی شرکت پردازش هوشمند مداد است.

حبیبی در ابتدا با مرور تاریخچه هوش مصنوعی به تمایزات بین هوش مصنوعی و انسان میپردازد و در نهایت این سوال را مطرح میکند که چگونه میتوان به هوش مصنوعی اعتماد کرد؟ در ادامه سید محسن موسوی به این سوال پاسخ داد که در پارادایم فعلی هوش مصنوعی این امر شدنی نیست. سید محسن موسوی، فارغالتحصیل رشته مهندسی برق از دانشگاه امیرکبیر است. موسوی همچنین تجربه کارآموزی در شرکت اپل در حوزه هوش مصنوعی را نیز دارد و در حال حاضر استاد امپریال کالج لندن است. موسوی و حبیبی در رویداد چامه، عدم مسئولیتپذیری هوش مصنوعی، راهحلهای اعتمادپذیر کردن آن و نحوه استفاده بهینه از هوش مصنوعی را توضیح میدهند.

جایگاه فناوریهای ساختهشده توسط بشر

انسان بودن!

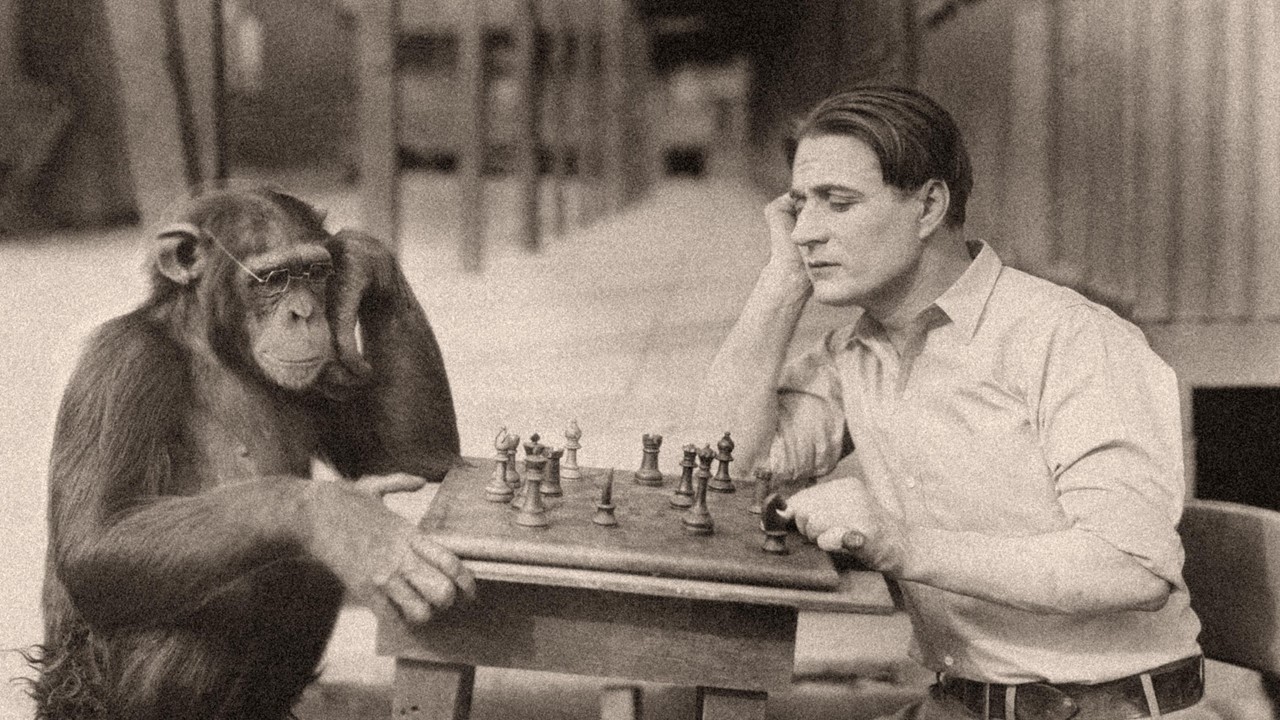

امیرحبیبی: در ابتدا میخواهم درباره مسئله انسانبودن صحبت کنم. . تفاوت ما با حیوانات این است که انسان را حیوان ناطق خطاب میکنند؛ یعنی وجه تمایز انسان با حیوان را توانایی منطق، فکر کردن و سخن گفتن میدانند.

از طرفی وقتی الان با chatGPT امکان صحبتکردن وجود دارد، این سوال مطرح میشود که با این سرعت پیشرفت تکنولوژی، در ۱۰ یا ۲۰ سال آینده تفاوت ما با ماشین چیست؟ ما مدت زیادی خود را اشرف مخلوقات میدانستیم و برتریهای واضحی نسبت به بقیه جهان طبیعت داشتیم.

ما فناوریهایی را ساختیم و با این فناوریها بخش زیادی از عوامل موثر بر جامعه را فتح کردیم. فناوری، به مرور زمان، صاحب هوش اندکی شد و البته آن موقع نیز یکسری تمایزات و برتریها نسبت به فناوری داشتیم. در ۵ سال اخیر و امسال (۱۴۰۱) وضع خوب نیست؛ زیرا با خود میگوییم، تکنولوژیای که با این سرعت پیش میرود، اگر ادامه پیدا کند چه اتفاقی میافتد؟

انسان و حیوان

تاریخچه و مسیر رشد هوشمصنوعی

سیر تکنولوژی را مرور کنیم؛ حدود دهه ۲۰ شمسی، اولین کامپیوترها ساختهشد. ۱۰ سال بعد اولین جرقههای هوشمصنوعی زده شد. همان ایام بود که پژوهشهایی برای شبیهسازی روی نورونهای مغزی صورت گرفت. همزمان نیز سختافزار در حال پیشرفت بود که در سال۱۳۹۲ ، فیسبوک مدلی را ارائه داد که معنای کلمات را بدون آموزش میفهمید؛ یعنی زمانی که یک متن را به آن میدادیم میتوانست معنا و ارتباط بین کلمات را تشخیص دهد؛ مثلا ارتباط بین کلمه مادر و پدر را با ملکه و شاه تشخیص میداد.

تاریخ تکنولوژی

این موضوع برای ۱۰ سال پیش بسیار حیرتآور بود و فکر میکردیم که دیگر اتفاق خاصی نمیافتد. چند سال بعد یعنی ۱۳۹۴ از سطح کلمه، به جمله رسیدیم؛ یعنی ماشین سطح خوبی از جملات را تشخیص میداد و تولید نیز اتفاق میافتاد. درواقع ماشین مفاهیم را از ورودی زبان انسان وارد نظاممعنایی خود میکرد. حدود سال ۱۳۹۶، ماشین توانست یک متن طولانی را تجزیه و تحلیل کند. امسال (۱۴۰۱) ما توانستیم به صورت مستقیم با ماشین مکالمه کنیم.

به نظر میآید که وضع خیلی خطرناک میشود، با این سرعتی که در طول این ۸۰ سال طی کردیم، در ۳۰ سال آینده، ماشینها عمده توانایی انسانها را خواهند داشت. دایره اختیارات انسان رفتهرفته کمتر میشود. در آینده تمایز انسان و ماشین چیست؟ تمایز بین تولیدات ماشین و انسان چیست؟ اگر نگاه عملگرایانه به این پدیده داشته باشیم، باید بپرسیم از ماشینها چه استفادهای میتوان کرد تا به سوال اصلی پاسخ داد.

هوش مصنوعی نمیتواند خلاق باشد!

خلاقیت نقطه تمایز انسان

یکی از جذابترین مواردی که در ماشینهای امروز وجود دارد، یادگیری ماشین است. ماشین میتواند حجم زیادی شعر بخواند و خود شاعر شود، مانند سایت بلبلزبان. در حالی که بچههای علوم انسانی ما در مدرسه، اوزان عروضی و ادبیات فارسی میخوانند اما چند درصد آنها شاعر میشوند؟ حتی بعضی از افرادی که شعر میگویند به صورت اساسی در وزنهای فارسی مشکل دارند. به نظر میآید که هوش ماشین از انسان در حال سبقت است. این موضوع غیرقابل پیشبینی بود و چنین چیزی انتظار نمیرفت.

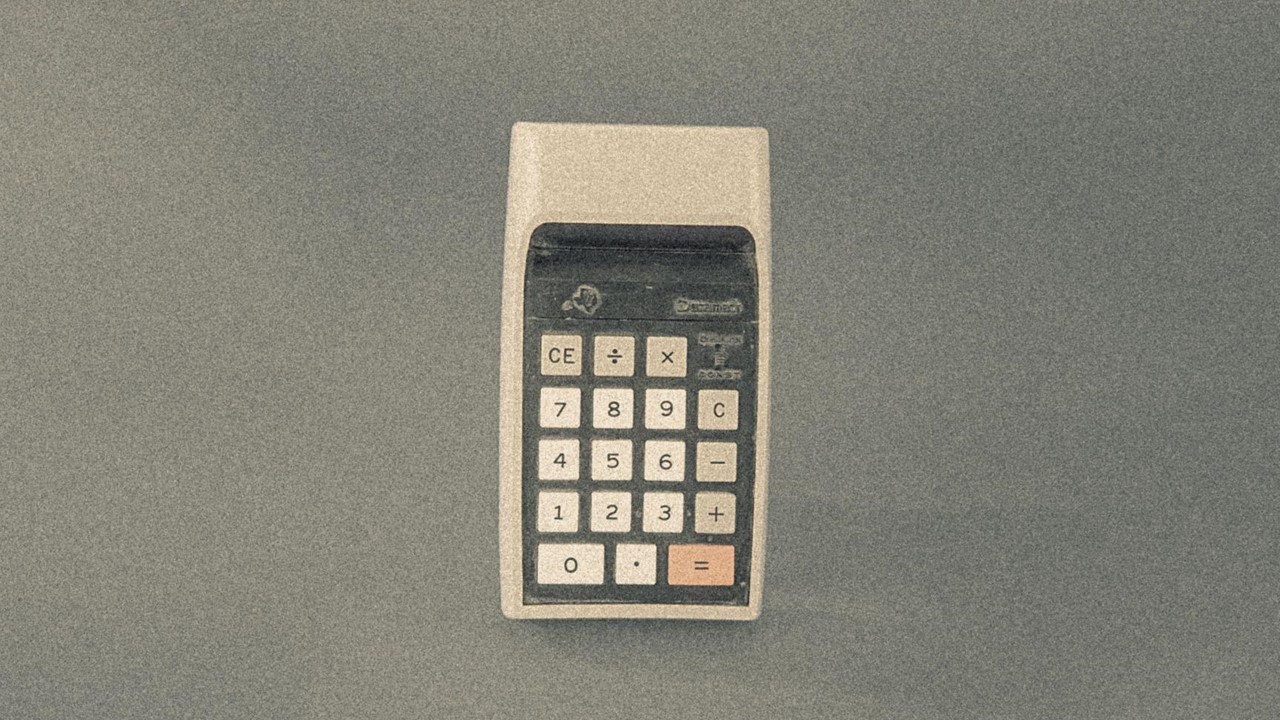

حال باید دید که هوش مصنوعی در خارج از چهارچوب تعریفی میتواند کار کند یا خیر؟ مثالی بزنم: بچههای کامپیوتر میدانند که ماشین به هیچوجه نمیتواند یک عدد تصادفی انتخاب کند و حتما باید چهارچوب خاصی را برای آن تعریف کرد. اینجا سوال پیش میآید که دکمه رندوم ماشین حساب چیست؟ در واقع الگوریتمی وجود دارد که دنبالهای را ایجاد میکند و اگر شما عدد اول آن دنباله را بدانید، میتوانید عدد بعدی را حدس بزنید. برای انتخاب یک عدد تصادفیتر، باید از عاملی خارج از چهارچوب محاسباتی ماشین استفاده کنیم. ماشین یک فرمول یا الگوریتم دارد که دقیقا اگر یک ورودی به آن بدهیم به شما یک خروجی تحویل میدهد. انتخاب تصادفی کار سختی است و میتوان گفت نمیتوان آن را انجام داد.

عدد تصادفی که تصادفی نیست!

هوش مصنوعی و خلاقیت

ماشین نتوانسته این مسئله را حل کند و به آن معنا خلاقیت داشته باشد؛ در حالی که میدجرنی (Mid Journey) یک اثر هنری را برای ما نقاشی میکند که خلاقانه به نظر میرسد؛ یا یک اثر را هوشمصنوعی Stable Diffusion میتواند نقاشی بکشد که یک مدل دیگر تولید عکس است. حتی تکنولوژی دال-ای2 (DALL.E2) که ادامه نقاشی داوینچی را به تصویر میکشد. از این موضوع خلاقانهتر؟! چیزی که باید به آن توجه کرد این است که تمام این مدل خلاقیتها و تنوع در خروجی ماشین، در پشت پیچیدگی سیستم پنهان شده است.

ابزار dall-e

زمانی که ما خیلی جزئی به سیستم ماشینها نگاه میکنیم، تصور ما این است که این یک سیستم قطعی است و همیشه برای یک ورودی باید یک خروجی دهد و اختیاری از خود ندارد و میتوان این موضوع را نقطه تمایز انسان و ماشین دانست.

تقدم ماشین بر انسان؟

تقدم ماشین بر انسان؟

دو دیدگاه در مورد انسان و ماشین وجود دارد. یکسری از کارشناسان علومشناختی از ما ایراد میگیرند که ما آزمایشهایی انجام دادهایم که انسان نیز ماشین پیچیدهای است و قابل پیشبینی است. آزمایش نیز اینگونه است: بخشی از نورونهای مغز که فعالیت الکتریکی درون آن انجام میشود و مربوط به تصمیمسازی انسان است، بخش دیگر مربوط به آگاهی از تصمیم است که تصمیم بر آگاهی تقدم دارد، یعنی اول ما تصمیم میگیریم و سپس آگاه خواهیمشد، فلذا انسان اختیار ندارد و یک سیستم جبری است.

از طرفی تعدادی از کارشناسان علوم اعصاب و علوم شناختی ماشین بودن انسان را به این شکل رد میکنند و تصمیمگیری را فرایند بسیار پیچیده میدانند. در هر صورت بین این دو جبهه دعوا وجود دارد که آیا تصمیمات ما بر فعالیت مغزی تقدم دارد یا خیر؟

پیچیدگی انسان

با قطعیت میتوان گفت که ماشین یک سیستم پیچیده است که همه چیز آن قطعی است اما مسئله هنوز حل نشده!

آزمایش تورینگ و آزمایش چینی

در این رویداد قصد داریم تفاوت تولیدات انسان و ماشین را درک کنیم. ابتدا آزمایشهایی را برای درک این مسئله بیان میکنم. دانشمندی به نام تورینگ در اوایل به میدان آمدن هوشمصنوعی، چهارچوبی را برای سنجش میزان هوشمندی هوشمصنوعی ارائه داد. گفت: «اگر بتوانم روزی هوش مصنوعیای بسازم که بتواند با یک فرد نامهنگاری کند و آن فرد نتواند تشخیص دهد که با هوش مصنوعی صحبت میکند، آن هوشمصنوعی بردهاست و هوش کاملی است». یعنی سنجه را تولیدات در نظر گرفته و گفته است که هوش مصنوعی اگر بتواند چیزی تولید کند که با انسان برابر باشد آن یک هوش مصنوعی کامل است. به این آزمایش «آزمایش تورینگ» میگویند.

آزمایش تورینگ و هوش مصنوعی

فردی به نام «جان سرل» تمثیلی به عنوان «اتاق چینی» ارائه داد. آزمایش به این صورت است که اگر فردی را داخل یک اتاق بگذارند و از زیر درب به او یک نامه به زبان چینی بدهند. با این فرض که فرد درون اتاق اصلا به زبان چینی مسلط نیست و با استفاده از کتاب آموزش چینی بتواند جواب نامه را بدهد. موضوع مهم این است که فرد داخل اتاق از نکات داخل نامه آگاهی ندارد و با استفاده از راهنما اینکار را انجام میدهد. جان سرل معتقد بود که تعبیر تورینگ در مورد هوشمصنوعی ایدهال، هوشمصنوعی ضعیفی است. هوشمصنوعی قوی از نظر جان سرل، هوش مصنوعی است که آگاهی و درک داشته باشد. به تعبیر دیگر هوشمصنوعی مورد نظر جانسرل دارای آگاهی و درک است.

آزمایش چینی و هوش مصنوعی

آیا میتوان به هوش مصنوعی اعتماد کرد؟

درک و آگاهی در انسان و هوش مصنوعی

بحث درک و آگاهی یک مسئله ریشهدار است. ارسطو در حدود ۲ تا ۳ هزار سال پیش درباره این موضوع صحبت کرده بود؛ به این معنا که اگر من میخواهم تصمیم بگیرم و انتخابی بکنم، قبل از آن نسبت به تصمیم خودم آگاهی دارم که چه انتخابی کنم. آگاهی چیز مهمی است و متفکران سالیان سال درباره این موضوع بحث میکردند. اگر بتوانم تشخیص دهم که ماشین آگاهی ندارد، میتوانم این نکته را یک وجه تمایز انسان و ماشین در نظر بگیرم. باز مسئلهای دیگر پیش میآید!

هدف من این است که ماشین کار من را انجام دهد، به من چه ربطی دارد که ماشین بفهمد یا نفهمد؟ من میخواهم کارم انجام شود و آدم عملگرایی هستم؛ در بخشی از جواب این سوال همه اتفاق نظر داریم؛ اینکه من اگر به هوش مصنوعی با نگاه ابزار نگاه کنم باید برای انجام کارم به آن اعتماد داشته باشم و به آن اتکا کنم. مخصوصا زمانی که قرار است از کارکرد این ابزار در بعد اجتماعی استفاده کنم. اگر آنموقع هوش مصنوعی به قوانین و آداب ما آشنا نباشد دیگر به دید ابزار نمیتوانیم به هوش مصنوعی نگاه مثبت داشته باشیم.

انسان و هوش مصنوعی

در ادامه بریم سراغ کسی که حوزه تخصصی و کارش اعتماد کردن و قابل اعتماد ساختن هوشمصنوعی است. آقای دکتر سیدمحسن موسوی، استاد امپریال کالج لندن.

پارادایمهای هوش مصنوعی

پارادایم هوش مصنوعی

امیر احمد حبیبی: آیا هوشمصنوعی میتواند ارزشها و مسائل اخلاقی را درک کند؟

سید محسن موسوی: قبل اینکه به این سوال پاسخ بدهم، بگذارید یک خلاصه از بخش اولی که شما گفتید را شرح دهم. این اتفاق باعث میشود که پارادایم فعلی هوش مصنوعی را بشناسید و بدانید چه پارادایمهای جایگزینی وجود دارد؟ پارادایم فعلی را اگر بخواهیم خلاصه کنیم، میتوانیم در سه عنصر دادههای عظیم، مدلهای محاسباتی پیچیده و قدرت سختافزاری بالا خلاصه کنیم.

پارادایم فعلی هوش مصنوعی

در این پارادایم کار ما چیست؟ کار ما این است که تعداد داده زیاد را به این مدلهای محاسباتی نشان دهیم و از آنها بخواهیم که ورودیها را به خروجی تبدیل کنند. انگار که ما تعداد زیادی مثال به این مدلها نشان میدهیم و آنها یاد میگیرند که چگونه این ورودیها را به خروجی تبدیل کنند. مثالش هم Midjourney، Dall-e و Stable Diffusion بود که آقای حبیبی نشان دادند. ما برای یادگیری این مدلها تعداد زیادی متن و تصویر مرتبط به این مدلها نشان دادیم و این مدلها با توجه به این دادهها به خوبی یاد گرفتند. حال که یک متن جدید به مدل دادیم، انتظار داریم که یک تصویر جدید متناسب با آن متن تولید کند. این پارادایم فعلی است.

پارادایم هوش مصنوعی در گذشته

در گذشته یعنی ۵۰ سال پیش نیز یک پارادایم وجود داشت که مردم امید زیادی به آن داشتند. آن پارادایم اینگونه بود که هوش مصنوعی را با دنبالکردن اصول منطقی و مشخص برای انسان بسازیم. یعنی ورودیای که در دست داریم را با چه منطقی تبدیل به خروجی کنیم؟ برای مثال زمانی که یک جمله را به ماشین میدهیم برای آن مشخص کنیم که قواعد جمله چه مواردی است؟ فعل، فاعل، اسم، حرف و… هر کدام از این اسمها چه ماهیتی دارند؟ حیوان، اشیاء، یک درختواره و نظام مفاهیم برای ماشین تعریف کنیم، به این صورت ماشین یاد میگیرد و ورودیها را به خروجی تبدیل میکند.

درک ارزشهای اخلاقی توسط هوش مصنوعی

درک ارزشهای اخلاقی توسط هوش مصنوعی

به سوال آقای حبیبی برگردم، آیا هوش مصنوعی ارزشهای اخلاقی ما را درک میکند؟ فکر میکنم بتوانید حدس بزنید که در پارادایم فعلی این موضوع شدنی نیست. البته اول باید بدانیم که منظور از درک چیست؟ اگر منظور ما همان تعریف پراگماتیسمی (عملگرایی) است که خروجی مدل یا هوش مصنوعی چیست؟

چه زمانی میگوییم یک فرد ما را درک میکند؟ پیش یک مشاور میرویم، درباره مسائل و مشکلات صحبت میکنیم و یک حس به ما دست میدهد که مشاور ما را درک میکند. اگر حس را تابعی از حرفهای مشاور یا زبان بدن مشاور در نظر بگیریم، بله میتوان گفت که هوش مصنوعی میتواند به این سطح از درک برسد؛ یعنی درک را بازی و تقلید کند. سوال اینجاست که آیا میتواند فراتر از این برود؟ این دیگر از حوزه علمی که من میشناسم خارج باشد. علمای فلسفه و اخلاق باید بگویند که آیا بر اساس خروجیها میتوان گفت که سیستم از خود اختیاری دارد؟ این مثال به آزمایش چینی نیز کمی شباهت دارد. تشخیصِ داشتن آگاهی آن سیستم از حوزه science خارج است.

عدممسئولیتپذیری هوش مصنوعی

عدم مسئولیتپذیری هوش مصنوعی

امیر احمد حبیبی: حوزههایی وجود دارند که نمیتوان در آنها به هوش مصنوعی اتکا کرد، لطفا چند نمونه از این حوزهها را ذکر کنید که ابهامهای ما حل شود.

سید محسن موسوی: مشکل که زیاد است اما بگذارید از اینجا شروع کنم. آیا هوش مصنوعی میتواند مسئولیت خروجیهای خود که شامل متن، تصویر و ویدئو است را برعهده بگیرد؟ شاید این یک جنبهی مهم است، در پارادایم فعلی ما نمیتوانیم هوش مصنوعی را مسئولیتپذیر بدانیم. فرض کنید که اتفاقی افتاده است و یک ماشین بخاطر خطای هوش مصنوعی تصادف کرده است. زمانی که هوش مصنوعی را مسئول بدانیم، به این معنا است که مسئولیت اصلی را از آدمهای دخیل در امر که Agency (نقش و وظیفه) داشتند، سلب کردهاید. در حال حاضر نمیتوان مسئولیتی را از کسی سلب کرد و بر دوش هوش مصنوعی گذاشت. مشکل بزرگتری نیز وجود دارد که حتی در پارادایم فعلی نمیتوان در مورد آدمها گفت که چه کسی مسئول است؛ کسی که داده را تولید کرده است؟ که آن هم بخشهای مختلف دارد؛ یا آن شخصی که الگوریتم یادگیری را طراحی کرده است؟

یک مثال، خودرو معمولی و خودران است. یک خودرو زمانی که تصادف میکند؛ مقصر راننده نیست و یک اشکال فنی باعث ایجاد تصادف شده است. خیلی راحت میتوان تشخیص داد که چه قطعهای ایراد دارد و آن قطعه مشکل طراحی دارد یا ایراد از سازنده است؟ میتوان مسئول را پیدا کرد.

پارادایم فعلی هوش مصنوعی قابل اعتماد نیست

مسئله اینجاست که در پارادایم فعلی نه تنها هوش مصنوعی مسئولیتپذیر نیست؛ حتی نمیدانیم اگر آن مدل شکست خورد یقه چه شخصی را بگیریم؛ چون هیچ ایدهای نداریم که چه کسی مقصر است؟ از داده است؟ و از کدام بخش داده است؟ از الگوریتم بوده است یا از نحوه استفاده از مدل بوده است؟ به همین خاطر در پارادایم فعلی نمیتوان گفت که هوش مصنوعی مسئولیتپذیر است و این موضوع اعتمادپذیری و اطمینانپذیری هوش مصنوعی را زیر سوال میبرد. شما زمانی که سوار ماشین میشوید، به راننده اعتماد میکنید و اگر اتفاقی بیفتد مسئول آن راننده است. در حالی که وقتی سوار یک خودروی خودران میشوید، نمیدانید مسئول آن کیست. این موضوع روی اعتماد و عدم اعتماد ما روی هوش مصنوعی تاثیر میگذارد.

راهحلهای اعتمادپذیر کردن هوش مصنوعی

امیر احمد حبیبی: مسئله تاثیرپذیری، یک مسئله حساس است. رویکرد ما برای حل این مشکلات چیست؟ راهحلهای بلندمدت یا کوتاهمدت ما به چه سمتی پیش میرود؟

سید محسن موسوی: خیلی از پژوهشگران روی این مسائل کار میکنند. بخش زیادی از پژوهشهای پژوهشگران این است که در پارادایم فعلی چگونه هوش مصنوعی را قابل اعتمادتر کنیم. چالشهای جدی نیز وجود دارد و بخشی از آنها بخاطر همین پارادایم به وجود میآیند. همین که تصمیم گرفتیم مدلها را با نشان دادن دادهها آموزش دهیم؛ یعنی از روابط علت و معلولی صرف نظر کردهایم.

یک بخشی از افراد معتقد هستند که پارادایم قبلی را با پارادایم فعلی ترکیب کنیم، اما هنوز اتفاق قابل توجهی نیفتاده است. چالشهای پیشِرو همه فنی نیستند و به مسائل اجتماعی نیز مرتبط میشوند؛ مثلا اگر جامعه هوش مصنوعی را به مثابه ترمیناتور فرض کند، دیگر نمیتواند به آن اعتماد کند. زیرا تصور میکند که هوش مصنوعی مردم را از بین میبرد. هرچند که بهبود مسائل فنی میتواند اعتماد ایجاد کند اما بیشتر مسائل به موارد اجتماعی مرتبط است.

عامل مهم دیگر بر ایجاد اعتماد، موارد حقوقی و قوانین مرتبط با هوش مصنوعی است. در گذشته حملونقل با اسب بوده و رفته رفته خودرو جای آن را گرفته است. در طول زمان، قوانین متناسب با تکنولوژی شکل میگیرد. مسلما برای هوش مصنوعی قوانین سازگار و مناسبی نیاز داریم. به نظر میرسد هنوز بخش تکنیکال (فنی) از بخشهای دیگر مهمتر است” چون هنوز به آن مرحله نرسیدیم که به حقوقدان بگوییم: برای این ابزار قوانین تنظیم کند و با اطمینان کامل به مردم بگوییم که اگر سوار o,nv, خودران شوید، دیگر برای شما اتفاقی نمیافتد. هنوز موارد فنی اولویت دارد.

هوش مصنوعی و میل به جاودانگی

میل به جاودانگی توسط هوش مصنوعی

سوال حاضران در رویداد: آیا به زمانی میرسیم که بتوانیم هوش مصنوعی یک سیستم را تهدید کنیم؟ یعنی هوش مصنوعی که میل به جاودانگی داشته باشد و ما آن را تهدید کنیم که تو را خاموش میکنیم و آن هوش مصنوعی بترسد.

سیدمحسن موسوی: در پارادایم فعلی من فکر نمیکنم چنین اتفاقی بیفتد. البته هوش مصنوعی چرا باید احساس خطر کند و میل به جاودانگی داشته باشد؟ زمانی که در مورد این موضوع صحبت میکنیم، موضوع دیگر فنی نیست و فلسفی میشود. زمانی که به دانش خودمان و پارادایم فعلی نگاه میکنم، جایی برای این موضوع نمیبینم.

آزادی عملدادن به هوش مصنوعی، موضوعی خطرناک!

سیدمحسن موسوی: آزادی هوش مصنوعی این است که هر خروجی که بخواهد بر اساس دادهها تحویل دهد. یعنی آزادی هوش مصنوعی در حیطه همان دادههای ورودی است. مثلا اگر یک حرف زشت به ChatGpt گفته شود، آن بررسی میکند و براساس جستوجو به این نکته میرسد که جواب حرف زشت، حرف زشت بدتر است. این همان آزادی عملی است که ما به هوش مصنوعی دادهایم. دادههایی که ChatGPT از آن به عنوان ورودی استفاده میکند، معمولا از دادههای گوگل است که غالبا مسموم است و سوگیری و دروغ بین آنها وجود دارد. زمانی که از این دادهها برای یادگیری مدل استفاده میکنیم به این معنا است که آزادی عمل به هوش مصنوعی دادهایم. به ماشین میگوییم از همان دادهای که دیدهای استفاده و تقلید کن. مدل، حرف گوش کن است و از آن دادهها نیز تبعیت میکند و اگر داده مسموم باشد، خروجی ماشین نیز مسموم است.

این موضوع خیلی خطرناک است. معضلی که در حال حاضر با آن مواجه هستیم، اخبار جعلی، تصاویر و فیلمهایی است که از اینترنت جمعآوری شده است. در نتیجه اینترنت، نمای خوبی از جامعه انسانی و اخلاق جامعه انسانی نیست. مدل (هوش مصنوعی) نیز یاد گرفته است که همان رفتارهای منفی را تکرار کند و ما نیز از این روند استفاده میکنیم و دادههای جدیدی تولید میشود.

آینده با هوش مصنوعی

پیشبینی میشود دادهای که در ۵ سال آینده قرار است در اینترنت تولید شود، توسط هوش مصنوعی خواهد بود نه توسط انسان، این زنگ خطر است. چون محتوای منفی روز به روز افزایش پیدا میکند و ما نیز از آن استفاده میکنیم و همین باعث میشود نسخههای جدیدتر هوش مصنوعی منتشر شود و این چرخه ادامه پیدا کند.

خطا برای هوش مصنوعی ضروری است

سوال حاضران در رویداد: سوال اول) خطا یک جزء جداییناپذیر از انسان است، ما میگوییم هوش مصنوعی به انسان خواهد رسید و بعد از آن پیشی میگیرد. آیا خطا برای هوش مصنوعی نیز یک بخش جداییناپذیر میشود؟

سید محسن موسوی: خطا بخش جداییناپذیر است، حتی Argument (استدلال) ریاضی میتوان انجام داد که اصلا خطا باید باشد تا یادگیری اتفاق بیفتد. ما با خطاها مسئلهای نداریم و خطا بخشی از کار است. مسئله اصلی این است که خطاها شناخته و حدود و ثغور آن مشخص شود. این است که باعث به وجود آمدن اعتماد میشود. مثلا در انسانها میدانیم که اگر فرد خسته باشد، احتمال خطای آن بالا میرود و زمان خوبی برای مشورتگرفتن از آن نیست. اگر فرد خسته باشد احتمال تصادف برای آن زیاد است. در مورد هوشمصنوعی نیز تمایل داریم بدانیم در چه مواقعی و در چه شرایطی هوش مصنوعی خطا میکند. پس سوال اصلی این نیست که آیا هوشمصنوعی خطا میکند یا خیر؟ بله. خطا میکند و از نظر ریاضی نیاز است که خطا کند. این مهمتر که هوش مصنوعی در چه مواقعی و شرایطی خطا میکند.

درک هوش مصنوعی چقدر است؟

سوال دوم) ما در یک کنشِ مساوی در شرایط متفاوت، واکنشهای متفاوتی داریم. حتی گاهی اوقات این واکنش متفاوت را انتخاب میکنیم. به طور مثال ما با کسی که رودروایسی داریم، آن حرفی که میخواهیم بزنیم را نمیزنیم. آیا هوش مصنوعی به این مرتبه از قدرت رسیده یا میرسد؟

درباره سوال دوم، این موضوع در حیطه science (علم) نیست. ولی بخش دیگر که درباره رودرواسی انسانها صحبت کردید، این رودرواسی نیز ورودی است، پس شرایط دقیقا یکی نیست. افرادی که به صورت deterministic (قطعی و قابل پیشبینی) فکر میکنند و معتقدند که انسان قابل پیشبینی است، در این حالت میگویند که زمانی که شما رودرواسی دارید و زمانی که رودرواسی ندارید، همه چیز یکسان است. رودرواسی از کجا میآید؟ از تجربه تعاملات قبلی شما با این فرد است و نمیتوان شرایط را دقیقا یکی دانست و شرایط دقیقا یکی نیست. شاید فردی بگوید اگر شرایط یکسان باشد، خروجی کار نیز یکسان است. خیلی موضوع سختی است که ثابت کنیم که برای دو فرد شرایط یکسان فراهم کنیم که واکنشهای متفاوت انجام دهند.

هوش مصنوعی برای مشاغل، تهدید یا فرصت؟

سوال حاضران در رویداد: من برای تولید محتوای سایتم از ChatGPT استفاده میکنم و زمان من را خیلی آزاد کرده است. سوال من این است که چه تهدیدی برای شغلهایی مثل تولید محتوا، وجود دارد؟

سید محسن موسوی: سوال خوبی است. تغییرات این مدلها را در زندگی مشاهده میکنیم. همین Deep Fake؛ ویدیوها و تصاویر فیکی که ایجاد شده است تاثیر میگذارد. مثلا در دادگاهها دیگر فیلم سند نیست و اعتماد را سخت میکند. خبر دروغ به صورت انبوه میتواند پخش شود. در گذشته خبر دروغ داشتیم اما الان خیلی راحت خبر دروغ تولید میشود و با دسترسی رایگان به چت جیپیتی میتوان این کار را انجام داد.

یک بحث دیگر این است که میگوییم برنامهنویسها و بقیه مشاغل بیکار میشوند؛ این بحث باید کمترین اهمیت را برای ما داشته باشد. زمانی که کامپیوترها جای محاسبه دستی را گرفتند، افراد مهارتهای بیشتری به دست آوردند و شغلی حذف نشد و فقط فرم شغلها تغییر کرد. من از این بابت نگران نیستم.

یک زمانی ما متن را به چتجیپیتی میدهیم و آن متن را خلاصه میکند، یکبار از آن میخواهیم که درباره تابستان یک توصیف و متنی به ما بدهد؛ آیا این متن منحصر به فرد و کپی از جای دیگری نیست؟ این را گفتم که مسئله بزرگتری را مطرح کنم.

نقض حریم خصوصی توسط هوش مصنوعی

مدلهای هوش مصنوعی حافظه خوبی دارند؛ در صورتی که ما دوست نداریم که هوش مصنوعی حافظه خوبی داشته باشند. دوست داریم که هوش مصنوعی خلاق باشد و فراتر از دادهای که دیده، عمل کند. متاسفانه مدلهای فعلی خواسته ما را فراهم نمیکنند. مدلهای قدیم ChatGPT (نسخه ۲)، آدرس، شماره تلفن و اسم فرد را میداند و ما انتظار این کار را نداشتیم. میدانیم تمام این اطلاعات در اینترنت است اما اینکه همه موارد را بخاطر بسپارد، حریم خصوصی را نقض میکند.

یک مسئله دیگر در اینترنت وجود دارد به اسم حق فراموشی؛ اگر شما در اینترنت مطلبی گذاشته باشید، میتوانید با توجه به قوانینی تحت عنوان GDPR مخفف General Data Protection Regulation به معنی «مقررات محافظت از دادههای عمومی» از آن سایت درخواست کنید که تمام اطلاعات شما را حذف کنند. شما نمیتوانید از شرکت Open Ai که سازنده ChatGPT بوده است درخواست کنید که اطلاعاتتان را حذف کند. میگوید:«شرمنده نمیتوانم حذف کنم و چگونه میتوانم حذف کنم؟».

پارادایم فعلی به گونهای است که به نمونه به ماشین نشان داده شده است و مکانیزم خاصی ندارد؛ من هم نمیتوانم بگویم نورونهای عصبی من مسئول داده فلان شخص است. این داده در همه سیستم پخش است و نمیتوان آن را حذف کرد و این باعث میشود که حق فراموشی نقض شود. زمانی که با استفاده از ابزار هوش مصنوعی یک تصویر تولید میکنید، ممکن است آن تصویر برای شخص دیگری باشد و مالکیت معنوی داشته باشد. این مسئله مهمی است و حریم خصوصی و مالکیت معنوی با این اتفاق زیرسوال میرود و دلیل آن بحث memorization «به خاطر سپردن» است که باید توسط افرادی که تولید محتوا میکنند مورد توجه قرار گیرد.

برای استفاده از هوش مصنوعی همه جوانب را در نظر بگیریم

موضوعی که حسنختام عرایض بنده است را خدمتتان عرض میکنم. حتی اگر جنبههای فلسفی را نادیده بگیرم، من در جایگاه پژوهشگر Science در خدمت شما هستم و بلد نیستم درباره فلسفه صحبت کنم. همین الان میتوانیم چشمهای خود را روی لیست بدها ببندیم و بگوییم این موضوع هم مثل روندهای دیگر تکنولوژی است.

همانطور که در گذشته ابزارهای انرژی کشف شد و نحوه استخراج انبوه انرژی را یاد گرفتیم، گرمایش زمین یا تغییرات اقلیم را در پی داشت و بحرانهایی را ایجاد کرد. کشف سلاح هستهای که سیاست، اقتصاد و… را تحت تاثیر خود قرار داد. اگر اثرات منفی را انکار کنیم، یعنی اتفاقات منفی و تجارب قبلی را انکار کردیم. یعنی میخواهیم اشتباهات قبل را دوباره تکرار کنیم؛ که من فکر میکنم بحرانهای بزرگتری ایجاد میشوند. اگر بمب اتم کلی کار بد انجام داد و ستون خوبی نداشت، هوش مصنوعی ستون خوبی دارد اما ستون بد زیادی هم دارد که میتواند بحرانهای وجودی ایجاد کند.

استفاده از هوش مصنوعی

آیا به سراغ هوش مصنوعی نرویم و تحقیق انجام ندهیم؟

نه، حرف این نیست؛ چون فکر میکنم در درازمدت ابزارها و تکنولوژی، خود را به ما دیکته میکنند و اگر ما روی آن کار نکنیم، شخص دیگر این کار را میکند. دیر یا زود هوش مصنوعی، خود، فرهنگ و بارش را به ما تحمیل میکند؛ در نتیجه فکر میکنم در سطح فردی بتوانیم تصمیمات مسئولانهتری بگیریم. زمانی که ما در جایگاه مهندس داده در یک شرکتی کار میکنیم، وقتی رئیس ما بخواهد، یک مسئلهای را حل کنیم، چون هوش مصنوعی روش ترندیست، نباید روشهای سنتی، Interpretable «قابل تفسیر» و white box را کنار بگذاریم. برای استفاده از ابزار هوش مصنوعی باید همه جوانب را از جمله حریم خصوصی، امنیت و سوگیری، در نظر بگیریم و یک وزن به آن بدهیم.

درک، آگاهی و حس برای هوش مصنوعی

امیراحمدحبیبی: بحث به جای مرتبطی رسید، تمرکز من روی انسان بودن بود. میخواستم درباره این صحبت کنم؛ دغدغه من این است که انسان چه کارهایی میتواند بکند؟ انسان ویژگیهایی دارد که ما از آن اطلاع نداریم. مثلا ما یک شبکه عصبی عمیقی دور معده و روده داریم که میتواند در حد مغز توانایی داشته باشد و به آن مغز دوم میگویند. هنوز نمیدانیم دقیقا چکار میکند و چه بخش از پردازشها را انجام میدهد.

ما در رفتارهای انسانی چیزی به اسم حس داریم، درک و آگاهی از جنس حس است. من اگر غذایی بخورم و لذت ببرم، از جنس حس است. عشقورزی از جنس حس است. این با آنچیزی که توانستیم اینجا محاسبه کنیم، جور درنمیآید.

دید ما به هنر و سلیقه متفاوت است و هر کدام از ما یک چیز متفاوت را زیبا میبینیم. یک بخش از زیبایی مربوط به نظم، چهارچوب، هماهنگی بین رنگها و اوزان و اصوات است؛ این به کنار، زیرا ماشین نیز میتواند این را تولید کند. یک بخش اساسی در بخش زیباییشناسیِ ما به این برمیگردد که کسی که این اثر را تولید کرده یک انسان بوده است و تجربیاتی که من داشتهام را داشته و این حس واقعیبودن خیلی مهم است که هوش مصنوعی این حس را ندارد.

بنشین بر لب جوی و گذر عمر ببین

حافظ میگوید:

بنشین بر لب جوی و گذر عمر ببین

کین اشارت ز جهان گذران ما را بس

احساسات تنها چیزی است که هوش مصنوعی آن را هیچ وقت درک نمیکند

هوش مصنوعی و احساسات

چیزی که باعث میشود از این شعر الهام بگیریم و با شعر تولیدشده هوش مصنوعی تفاوت داشته باشد، تجربیات یک شاعر در قرن هشتم است. یعنی یک آقایی در قرن هشتم بر لب یک جویی نشسته و احساساتش قلیان کرده است. این از فرم خود شعر و قافیه آن خیلی مهمتر است، که هوش مصنوعی نیز توانایی ساخت آن را در فرم و وزن دارد. پشت این اتفاقات من یک انسان را میبینم که فاعل بوده است.

فعالیت انسان یک مسئله اساسی و مهم در طول تاریخ است. رشد ما از فعالیت ما است نه زمانی که مفعول واقع میشویم. یک مثال ساده، شما اگر بخواهید زبان انگلیسی یاد بگیرید و ۱۰ سال پادکست گوش دهید و فیلم ببینید، به اندازه یک سال انگلیسی خواندن به صورت عملیاتی در محیط موثر نیست. البته من قصد تقلیل فاعلیت به آموختن مهارت ندارم، فعالیت و رشد انسان فراتر از آموختن مهارت است اما چیز اساسی است.

هوش مصنوعی و سلب قدرت تفکر

هوش مصنوعی و سلب قدرت تفکر

ما میخواستیم از چنگ نیروهای خارجی آزاد شویم و به سراغ ساخت تکنولوژی رفتیم تا با غلبه به محیط پیرامون خود آزادی داشته باشیم اما همین تکنولوژیها آزادی ما را سلب کردند. ما تصمیم گرفتیم خیلی از اختیارات خود را به ماشین بسپاریم، برای گفتوگو با اشخاص از پیام متنی استفاده میکنیم که باعث شد خیلی از احساسات ما دیگر به مخاطب و طرف مقابل منتقل نشوند.

برای پیدا کردن یک آدرس از بلد و نشان استفاده میکنم؛ یعنی یک قسمت زیادی از آگاهی و درک جغرافیای شهری را به هوش مصنوعی سپردم و تصمیم میگیرم، دیگر فکر نمیکنم. تصمیم میگیرم دیگر از ذهنم استفاده نکنم و آن را تنبل کنم و از ظرفیت ذهنم بهرهمند نشوم. ما داریم تصمیم میگیریم که فرمانبردار باشیم و برای این موضوع تصمیم نگیریم.

تکنولوژی آزادی ما را محدود کرده است. خیلی از اندیشمندان، از گذشته معتقد بودند که ذات تکنولوژی، خاصیت چهارچوبساز دارد و ما را مجبور میکند که در یک چهارچوب کار کنیم.

انسان بودن!

خودشناسی

در این بین دعوایی وجود دارد بین افرادی که موافق تکنولوژی و پیشرفتهای ناشی از آن هستند و افرادی نیز مخالف تکنولوژی و طرفدار طبیعتاند. در این دعوا ما چیز دیگری را گم کردیم و آن حد اعلی فعالیت انسان بوده است. مسئله اصلی ما این نبود که عوامل بیرونی را کنترل و محدود کنیم بلکه مسئله ما کنترل مسائل درونی ماست. ما باید خود را بشناسیم و بر خواستههای درونی تسلط پیدا کنیم. زمانی آزادیم که بتوانیم از بند خود رها باشیم. این آزادی رشد ما را در پی دارد.

حافظ خیلی زیبا میگوید:

که ای بلندنظر شاهبازِ سِدره نشین

نشیمن تو نه این کُنجِ محنت آبادست

تو را ز کنگرهٔ عرش میزنند صفیر

ندانمت که در این دامگه چه افتادست

سوال ما نباید این باشد که ماشین و هوش مصنوعی در ۳۰ سال آینده چه بارهایی را از دوش ما برمیدارد. سوال مهمتر این است که من میخواهم چه بارهایی را روی دوش خود نگه دارم.

امیراحمد حبیبی